作为一个专注于硅谷高科技的网站,我们就不为大家总结苹果新iPhone长什么样(懒人包请点击这里)以及有哪些新功能了。相信你可以通过访问官网了解到。

但是我为什么推荐你看这篇文章:在今天成千上万篇与苹果新产品发布相关的文章中,我相信很少有像这篇这样的文章能为你勾勒出这次发布的真正重点。

没有更多的麻烦,正文开始了。

重点:A12仿生处理器

A12仿生处理器驱动最新一代iPhone XS和XR,是苹果秋季新品发布会的主角之一。

这次会议一半以上的时间是由苹果致力于A12 Bionic(以下简称A12)的参数和能力。我甚至认为这个SoC对苹果来说比iPhone本身更重要。

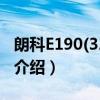

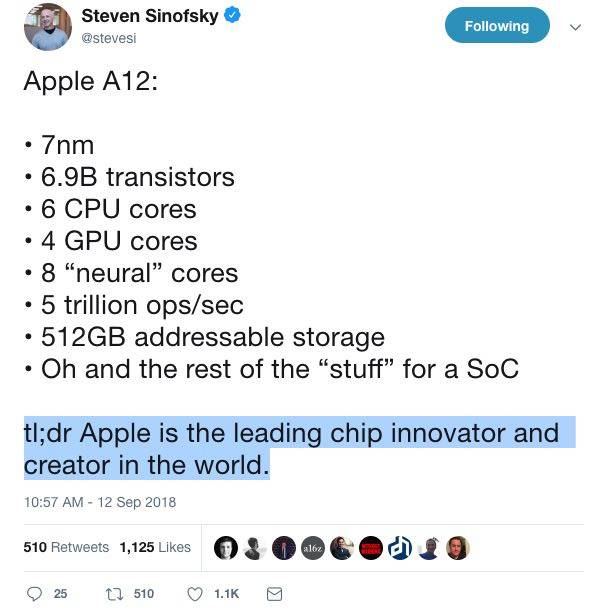

该芯片主要由中央处理器、图形处理器和神经网络引擎组成。CPU为6核;GPU有4核,性能比上一代A11高一半左右。

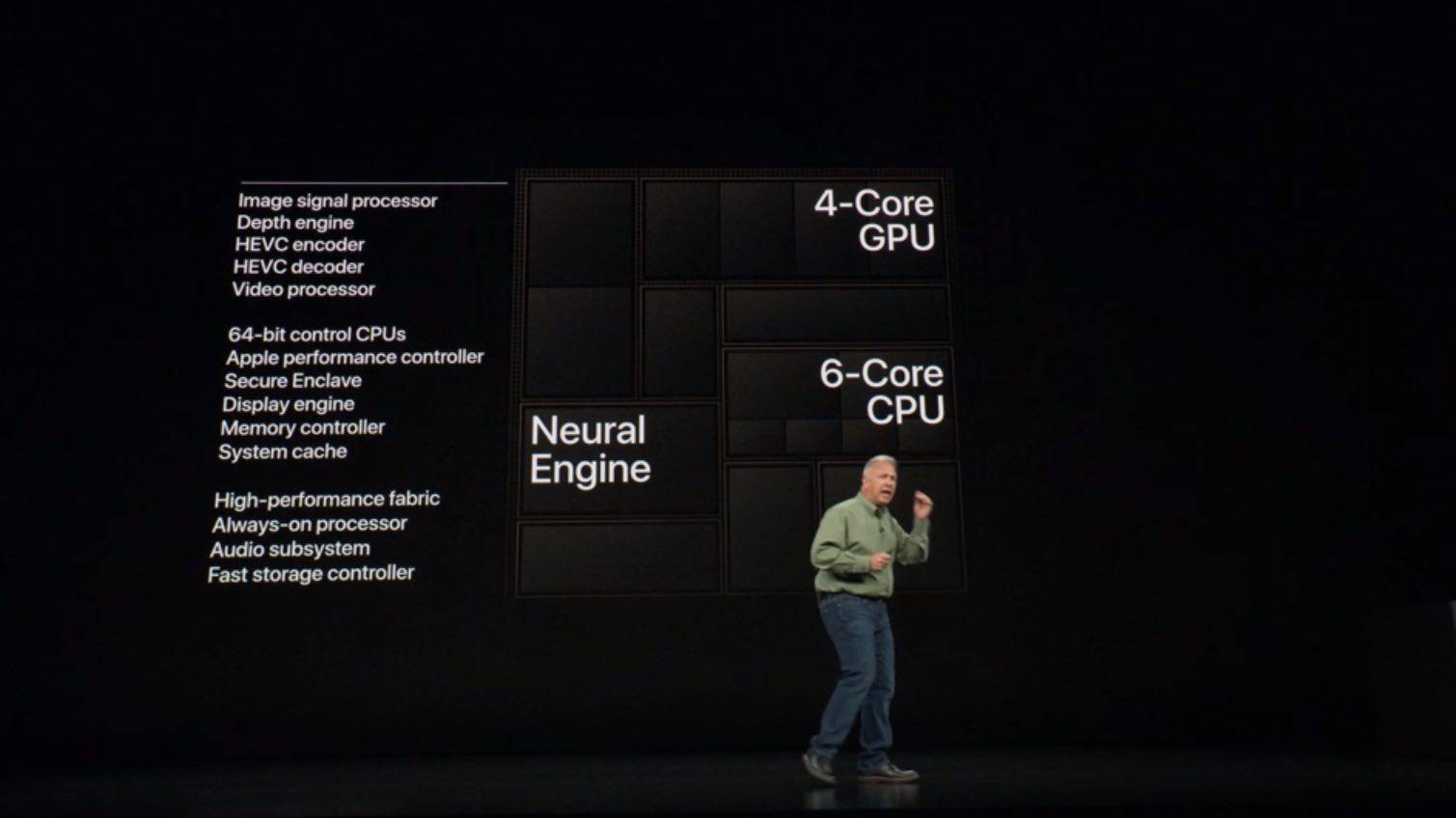

据苹果全球营销高级副总裁菲尔席勒介绍,A12是全球计算机行业首款7 nm处理器。

这是一个令人震惊的说法。因为科技从业者可能知道,芯片行业的龙头主要是英特尔、英伟达、AMD、高通等公司,而这些公司正在集体碰上天花板。

这个上限就是摩尔定律。

来自英特尔创始人的摩尔定律,描述了计算机行业的一个正常现象:因为技术的提升,处理器的性能每隔一段时间就会提升一次,成本也会降低。

然而,在过去的几年里,摩尔定律变得越来越难以实施。以世界上大多数计算机处理器的制造商英特尔——为例。其技术创新越来越慢,在10 nm工艺技术上的进步缓慢,导致其所依赖的技术进化模式崩溃。

计算机的对立面是移动SoC。高通是这个领域的佼佼者,进步也不差。最新一代的骁龙845处理器采用10 nm制程技术,已经进入了几款最新的手机。然而,高通遇到的问题是,性能提升和工艺进步之间的线性关系正在慢慢消退,这也是高通在新一代处理器中注重平台效应而非性能的原因。

没人想到,就在英特尔和高通与摩尔定律作斗争的时候,苹果突然用去年的A11和今年的A12来刷自己在芯片行业的存在感。

席勒透露,苹果(连同其代工厂TSMC)用7 nm制程技术将近70亿个晶体管封装到A12处理器中,使A12成为苹果制造的、乃至整个移动芯片行业历史上最强大的手机处理器。

3354别忘了,这家公司不像高通那样冒充芯片公司。

A12的6核处理器依然采用了自己的Fusion架构,分为2个高性能核和4个低功耗核,分别处理前台高资源和后台待机的任务,整体功耗降低了近50%。与上一代相比,4核图形处理器的性能也有了很大的提升。

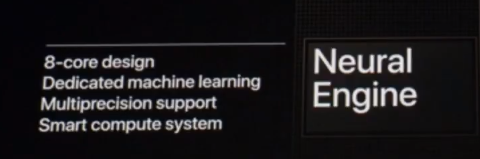

但芯片上苹果真正的杀手锏在于神经引擎。

这是一种FPGA(现场可编程门阵列),一种定制能力很强的集成电路,目前广泛应用于机器学习领域。

与A11的双核相比,A12的神经引擎内核数量飙升至8个。它们的存在是为了:

1)在局部侧处理神经网络任务,例如图像识别、目标跟踪和空间位置感测。

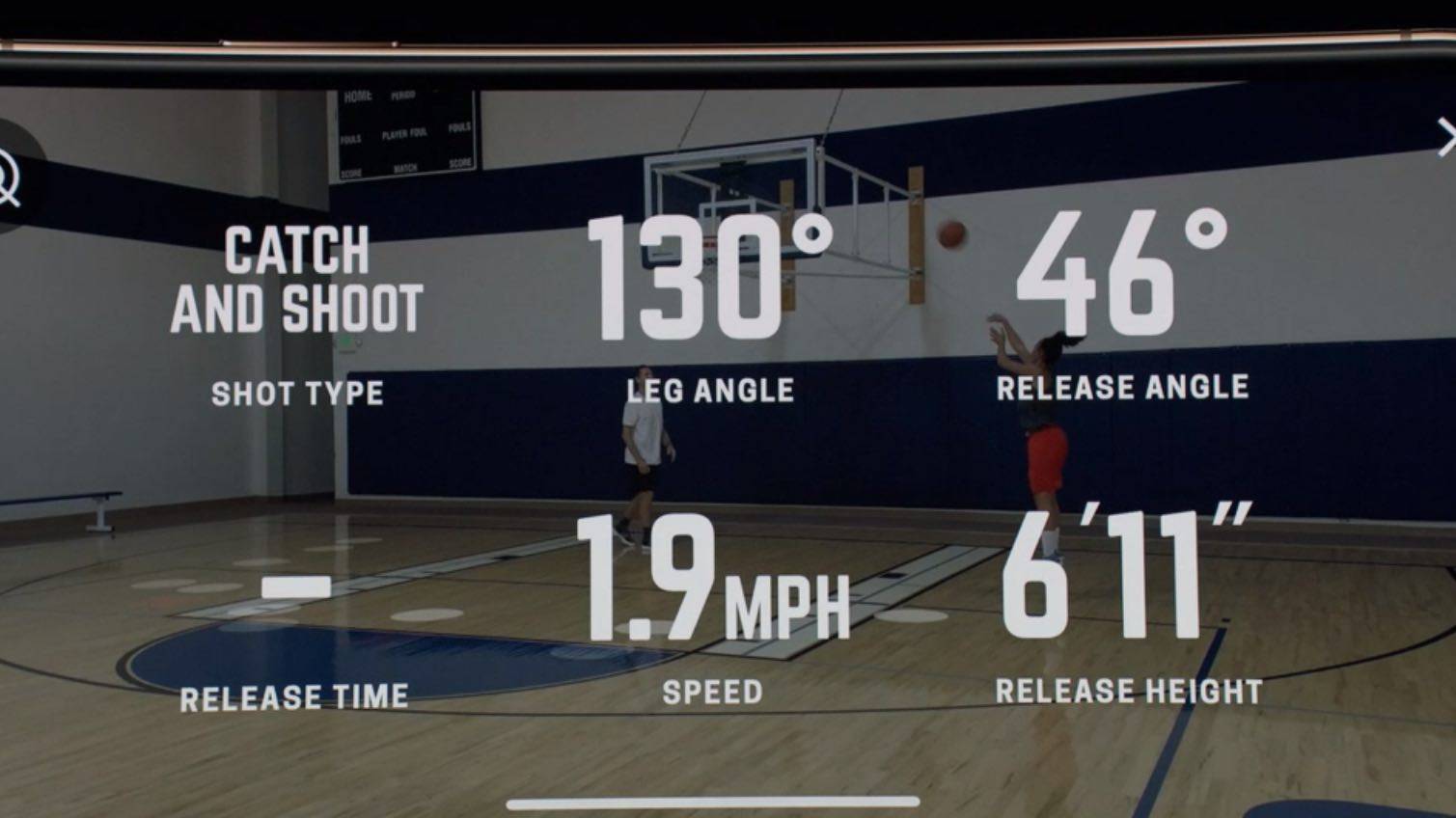

比如直播演示的篮球实时数据分析技术Homecourt Shotscience,可以即时监控球员的位置和姿势,球的高度、角度和时机等。

" width="1509" />

2)A12 Neural Engine 的第二个重要任务是为CPU 和GPU,以及在两个单元的不同核心之间进行任务分配,达成更高效的任务处理,提高性能、降低功耗。

第二代Neural Engine的存在,不仅展现了苹果在晶片设计上的强大,更证明了一件事:为了在设备上达成甚至创造新的用户需求,让iPhone比前一代更加尽善尽美,苹果愿意深入到晶片的层面。

而这和新iPhone 的第二个重点有关。

重点二:人工智慧

整场发表会给我留下深刻印象的点并不多,其中之一就是前面提到的篮球即时数据分析软体Homecourt。

科技从业者可能知道,人工智慧是硬体和软体的结合。具体来想要有好的效果,不仅要有高性能的计算硬体,也要有强大的算法和软体支援。

搭配苹果的CoreML 深度学习框架,新一代iPhone 每秒可以进行的神经网路计算超过5兆次。这意味着在某些特定范围内,最新一代iPhone 已经超越了不久前业界顶尖的伺服器超级电脑。

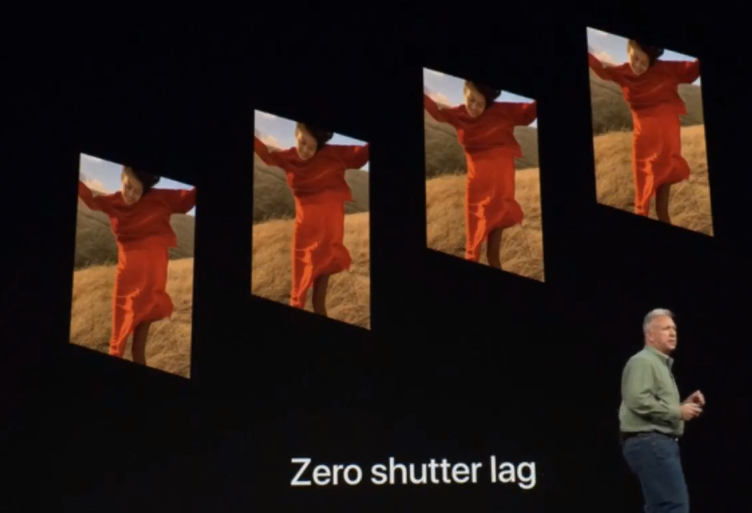

当很多神经网路等级的任务可以在本机端计算,无需连接网路,最大的意义在于解锁了很多新的使用情境。比如发表会示范的新一代iPhone 拍照的Smart HDR 功能。

HDR 拍照就是在按下快门时,相机会拍下多张不同曝光的照片,将它们拼在一起,使得从高光到暗影的每一处细节都呈现更清晰。iPhone XS 和XR 相机引入的Smart HDR 功能,利用了这个逻辑,达成了更好的效果。

首先,按下快门时相机会自动拍下4张照片,利用Neural Engine 结合GPU 的计算能力选取最好的一张。苹果称其为零快门延时(Zero shutter lag)技术。

但过程并非如此简单,再按下快门时,相机不仅留下了4帧,还在另一个曝光等级上拍摄了它们的复制帧,以保留高光细节;

以及另外一帧高曝光,留下暗处细节。此谓HDR。

最后,Neural Engine 会再次选取照片中品质最优良的几张,包括正片、高光、暗影,将其结合,从而达成Smart HDR 效果:

最后得到的照片并不一定就和普通HDR 或者HDR+ 照片高下立判。但需要明确的是,这些功能并非过去的手机拍照处理器/ISP 可以达成的,而是需要Neural Engine 和CPU/GPU 配合。

你可以说苹果杀鸡用牛刀,但至少在拍照这件事上他们是认真的。

同样是在拍照上,新一代iPhone 可以达成更好的背景模糊(Bokeh) 效果。前代iPhone X 刚发表时很多用户发现人像模式效果并不好,原因在于并非双镜头达成,而是单镜头+电脑模拟背景模糊。

席勒表示,苹果相机工程师利用市面上顶级的相机和镜头所拍下的背景模糊效果,对iPhone 相机、软体以及A12 Neural Engine 进行训练,相信能够取得更好的背景模糊效果——尽管这次仍然是电脑模拟的。

另一个例子是现场demo的多人同萤幕——不对,同空间联机游戏。这是一款扩增实境(AR) 3D射击游戏,几个玩家各自操作手机,在同一个空间内射击目标,最后比较比分。

这款游戏利用了苹果的ARKit 2 平台,结合Neural Engine 驱动的图像辨识和空间感知能力,至少在发表会现场效果令人叹服。

看完整场发表会,苹果在iPhone XS/XR上展现的人工智慧软硬体能力,给我留下的印象并不是它们有多强,而是在于它们整合的多么紧密和自然。

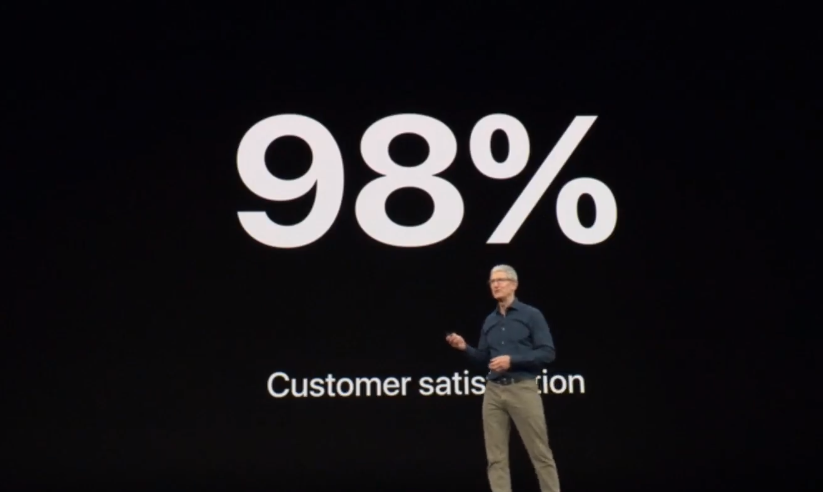

因为究其根本,苹果也不是一家人工智慧公司。它的业绩保证需要销售设备来支援。而设备给人带来的体验多完整,决定了设备的用户满意度有多高。